决策树分为两个主要类型:分类树和回归树。分类树是针对目标为离散型的情况,即最终目标是预测各样本的所属类别;回归树适用于目标变量为连续型。

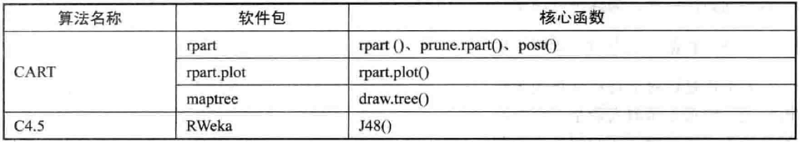

决策树的常用算法:CART(Classification and Regression Trees)和C4.5(successor of ID3)。

分类回归树CART是既可以建立分类树,也可以构造回归树的算法,是许多集成分类算法的基分类器。根节点或中间节点的字段选择指标是基尼指数。

C4.5是ID3(Iterative Dichotomiser 3)的改进算法,两者都以熵(Entropy)理论和信息增益理论为基础。其中,ID3的字段选择指标是信息增益,C4.5的字段选择指标是信息增益率。两者都只能针对离散型因变量进行分类。

在R中的实现方式如下图所示:

rpart()函数:rpart(formula, data, weights, subset, na.action = na.rpart, method, model = FALSE, x = FALSE,SE,Y = TRUE, parms, control, cost, ...)

J48()函数:J48(formu1a, data, subset, na.action, control = Weka_control(), options = NULL)

额……因为mvpart包已经不适用于新版的Rstudio,所以下载不了数据集,决策树的笔记就记录不了了[手动狗头]……

- 本笔记基于黄文和王正林编著的《数据挖掘:R语言实战》整理